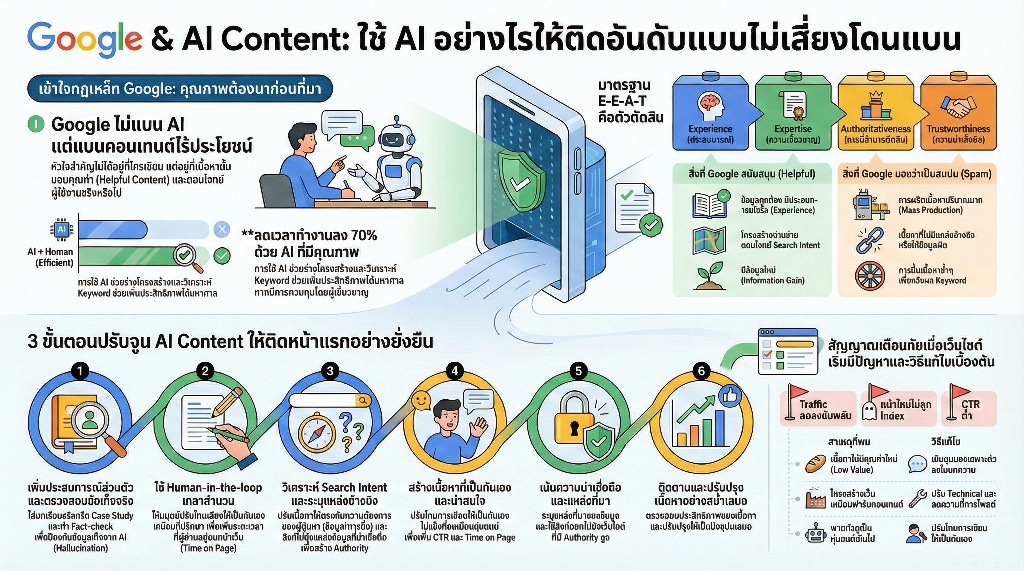

คำตอบสั้นๆ ที่หลายคนกังวลคือ Google ไม่ได้แบนเนื้อหาที่สร้างโดย AI ครับ เพราะหัวใจสำคัญไม่ได้อยู่ที่ว่าใครเขียนแต่อยู่ที่เขียนเพื่อใครและมีประโยชน์จริงไหมตราบใดที่คุณใช้ AI เป็นเครื่องมือช่วยสร้างคุณค่า (Helpful Content) ภายใต้มาตรฐาน E-E-A-T โดยไม่จงใจปั่นยอดเพื่อหลอกระบบ Search Engine คุณก็สามารถใช้ AI ช่วยสร้างงานที่เติบโตบนหน้าแรกได้อย่างปลอดภัยครับ

เพื่อให้ทุกคนนำไปปรับใช้ได้ทันที ผมได้สรุปเนื้อหาออกเป็น 3 ส่วนหลัก ตั้งแต่การทำความเข้าใจนโยบายล่าสุดของ Google อย่างถูกต้อง, เจาะลึกสิ่งที่ควรทำและข้อห้ามที่เสี่ยงโดนทำโทษจากประสบการณ์จริง, ไปจนถึงเทคนิคการปรับจูนเนื้อหา AI ให้มีคุณภาพและเข้าถึงใจผู้อ่าน เพื่อให้เว็บไซต์ของคุณเติบโตอย่างยั่งยืนโดยไม่ต้องกังวลเรื่องการโดนลดอันดับครับ

สรุปประเด็นสำคัญจาก WarriorSEO (Expert Take)

- Google ยอมรับเนื้อหาที่สร้างโดย AI แต่หัวใจสำคัญคือต้องมอบคุณค่าและเป็นไปตามมาตรฐาน E-E-A-T เพื่อให้ติดอันดับได้อย่างยั่งยืน

- ความเสี่ยงของการถูกลงโทษไม่ได้อยู่ที่การใช้ AI แต่อยู่ที่การผลิตเนื้อหาปริมาณมาก (Mass Production) ที่ไร้คุณภาพและไม่ตอบโจทย์ Search Intent ของผู้ใช้งาน

- การปรับแต่งเนื้อหาด้วยเทคนิค Human-in-the-loop เพื่อเพิ่มประสบการณ์ส่วนตัว (Experience) และการตรวจสอบข้อเท็จจริง (Fact-Check) คือขั้นตอนสำคัญที่ช่วยให้เนื้อหาปลอดภัยจาก Spam Update

- การสร้างความน่าเชื่อถือผ่านแหล่งอ้างอิงและการจัดโครงสร้างบทความให้อ่านง่าย จะช่วยสร้าง Authority ให้เว็บไซต์เติบโตได้ในระยะยาวโดยไม่ต้องกังวลการเปลี่ยนอัลกอริทึม

Table of Contents

เคล็ดลับการทำ AI Content ให้ติดหน้าแรก Google แบบยั่งยืน

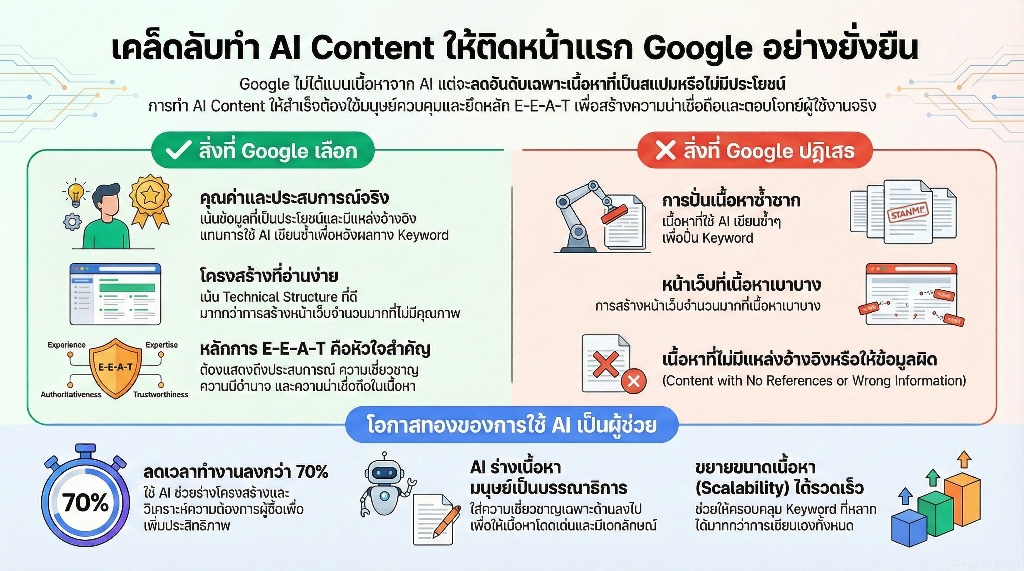

Google ให้ความสำคัญกับคุณภาพและคุณค่าของเนื้อหาเป็นอันดับหนึ่งโดยไม่เกี่ยงว่าใครหรือสิ่งใดเป็นผู้ผลิต การทำให้ AI Content ติดอันดับอย่างยั่งยืนจึงต้องยึดหลัก E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) เพื่อตอบโจทย์สิ่งที่ผู้ใช้กำลังค้นหาอย่างตรงจุดและมีความน่าเชื่อถือสูงที่สุด

ความจริงที่ Google ยอมรับเนื้อหาที่ผลิตโดย AI

นโยบายของ Google ระบุชัดเจนว่าไม่ได้แบนเนื้อหาที่สร้างโดย AI แต่จะลดอันดับเฉพาะเนื้อหาที่จงใจสร้างมาเพื่อปั่นอันดับ (Spam) หรือเนื้อหาที่ไม่มีประโยชน์ต่อผู้อ่าน จากประสบการณ์ที่ผมเคยรับงานกู้วิกฤตเว็บไซต์ที่ Traffic หายไปเกือบหมด พบว่าสาเหตุส่วนใหญ่มาจากการใช้ AI ผลิตเนื้อหาแบบไร้ทิศทางและขาดการตรวจสอบความถูกต้อง การปรับจูน AI ให้ทำงานภายใต้การควบคุมของประสบการณ์มนุษย์จึงเป็นกุญแจสำคัญที่ทำให้เว็บไซต์กลับมาเติบโตได้อีกครั้ง

| สิ่งที่ Google ให้ความสำคัญ | สิ่งที่ Google มองว่าเป็นสแปม |

| เนื้อหาที่ให้ข้อมูลถูกต้องและเป็นประโยชน์ | เนื้อหาที่ใช้ AI เขียนซ้ำๆ เพื่อหวังผลทาง Keyword |

| การนำเสนอประสบการณ์จริง (Experience) | เนื้อหาที่ไม่มีแหล่งอ้างอิงหรือให้ข้อมูลที่ผิดพลาด |

| โครงสร้างเว็บไซต์ที่อ่านง่าย (Technical Structure) | การสร้างหน้าเว็บจำนวนมากที่เนื้อหาเบาบาง (Thin Content) |

โอกาสทองของการใช้ AI สร้าง Traffic มหาศาลในยุคใหม่

AI ช่วยให้เราขยายขนาดการทำเนื้อหา (Scalability) ได้อย่างรวดเร็วโดยไม่เสียคุณภาพหากรู้วิธีการควบคุมที่ถูกต้อง บทเรียนจากการปั้นเว็บ E-commerce จนติดหน้า 1 Google สอนให้รู้ว่าการใช้ AI ช่วยร่างโครงสร้างเนื้อหาและวิเคราะห์ความต้องการของผู้ซื้อ ช่วยลดเวลาการทำงานลงกว่า 70% และเพิ่มโอกาสในการครอบคลุม Keyword ที่หลากหลายได้มากกว่าการเขียนเองทั้งหมดเพียงอย่างเดียว

การใช้ AI ในฐานะผู้ช่วยวิจัยและผู้ร่างเนื้อหาคือทางลัดที่ทรงพลังที่สุดในปัจจุบัน โดยเราทำหน้าที่เป็นบรรณาธิการที่ใส่ความเชี่ยวชาญเฉพาะด้านลงไปเพื่อให้เนื้อหานั้นมีเอกลักษณ์ไม่ซ้ำใคร การปรับปรุงทั้ง Content และ Technical Structure ควบคู่กันไปจะช่วยให้ Organic Traffic เติบโตอย่างมั่นคงในระยะยาว

แม้ว่า Google จะเปิดโอกาสให้ใช้ AI ได้อย่างอิสระ แต่ความเสี่ยงที่จะถูกลดอันดับยังคงมีอยู่หากเราก้าวพลาดเพียงนิดเดียว ซึ่งนำไปสู่คำถามสำคัญที่เจ้าของเว็บไซต์ต้องระวังคือ ทำไม AI Content ส่วนใหญ่ถึงเสี่ยงโดน Google ลงโทษและเราจะป้องกันได้อย่างไร

ทำไม AI Content ส่วนใหญ่ถึงเสี่ยงโดน Google ลงโทษ

Google ลงโทษ AI Content เมื่อเนื้อหานั้นถูกระบุว่าเป็นScaled Content Abuseหรือการใช้ระบบอัตโนมัติผลิตเนื้อหาปริมาณมากที่ขาดคุณภาพและไม่มีข้อมูลใหม่ที่เป็นประโยชน์ต่อผู้ใช้งานจริง โดยเป้าหมายหลักของ Google ไม่ใช่การแบน AI แต่คือการกำจัดเนื้อหาที่สร้างขึ้นเพื่อหวังผลทางการจัดอันดับเพียงอย่างเดียวโดยไม่คำนึงถึงประสบการณ์ของผู้อ่าน

กับดักการปั๊มเนื้อหาปริมาณมาก (Mass Production)

การผลิตเนื้อหาหลักร้อยบทความในเวลาอันสั้นผ่าน AI มักนำไปสู่ภาวะเนื้อหาซ้ำซากและขาดสาระสำคัญ (Thin Content) ซึ่งเป็นสัญญาณแรกที่ระบบตรวจสอบสแปมของ Google จะตรวจพบ จากประสบการณ์ที่เคยช่วยกู้วิกฤตเว็บไซต์ที่ Traffic หายไปเกือบทั้งหมด พบว่าสาเหตุหลักมาจากการเน้นปริมาณจนลืมตรวจสอบความถูกต้องและความสดใหม่ของข้อมูล การแก้ไขที่ได้ผลที่สุดคือการคัดกรองบทความที่ไม่มีคุณภาพออก แล้วรวมเนื้อหาที่มีหัวข้อใกล้เคียงกันให้กลายเป็นบทความที่ลึกและครอบคลุมเพียงหน้าเดียว

การมุ่งเน้นที่ Topic Authority หรือการเป็นตัวจริงในหัวข้อนั้นๆ สำคัญกว่าการมีจำนวนบทความมหาศาลแต่ไร้ทิศทาง การใช้ AI เป็นเพียงเครื่องมือช่วยร่างโครงสร้างแล้วเติมข้อมูลเชิงลึกจากประสบการณ์การทำงานจริง จะช่วยให้เว็บไซต์เติบโตได้อย่างยั่งยืนมากกว่าการปั๊ม Keyword ไปวันๆ

อ่านต่อบทความที่เกี่ยวข้อง หัวข้อกลยุทธ์การวางโครงสร้างคอนเทนต์ให้ยั่งยืน

ความเข้าใจผิดเกี่ยวกับกฎ Spam Update ล่าสุด

Google ไม่ได้ห้ามใช้ AI เขียนบทความ แต่ห้ามการใช้ AI เพื่อปั่นอันดับโดยไร้การควบคุมคุณภาพ ความเข้าใจผิดที่ว่า AI Content จะถูกแบน 100% ทำให้หลายธุรกิจเสียโอกาสในการเพิ่มประสิทธิภาพการทำงาน ตลอดระยะเวลา 10 ปีที่ผ่านมาในการทำ SEO กฎเหล็กที่ยังคงอยู่คือการทำเนื้อหาให้ตอบโจทย์ Search Intent ของผู้ใช้ให้ดีที่สุด หาก AI เขียนบทความที่อ่านง่ายและแก้ปัญหาได้จริง เนื้อหานั้นย่อมมีความปลอดภัย

บทเรียนจากการปั้นเว็บไซต์ E-commerce ให้ติดหน้า 1 คือการใช้ AI ช่วยวิเคราะห์ Pain Point ของลูกค้า แล้วนำมาเรียบเรียงใหม่ด้วยภาษาที่เป็นมนุษย์พร้อมสอดแทรกคำแนะนำจากประสบการณ์ตรง การทำแบบนี้ไม่เพียงแต่จะรอดพ้นจาก Spam Update แต่ยังช่วยเพิ่มอัตราการเปลี่ยนเป็นยอดขาย (Conversion Rate) ได้จริง เพราะผู้อ่านสัมผัสได้ถึงความเชี่ยวชาญที่หุ่นยนต์เลียนแบบไม่ได้

สัญญาณเตือนเมื่อเนื้อหาถูกมองว่าไร้ประโยชน์ต่อผู้อ่าน

อันดับที่ร่วงลงอย่างรวดเร็วพร้อมกับจำนวนหน้าที่ถูก Index ลดลง คือสัญญาณเตือนภัยขั้นรุนแรงว่าเนื้อหาของคุณกำลังถูกมองว่าเป็นสแปม เมื่อ Google Bot ตรวจพบว่าบทความบนเว็บไม่มีข้อมูลใหม่(Information Gain) หรือเป็นการนำเนื้อหาจากเว็บอื่นมาหมุนคำใหม่ (Spin Content) โดย AI ระบบจะลดความสำคัญของเว็บไซต์นั้นทันที

| สัญญาณเตือน | สาเหตุที่พบส่วนใหญ่ | วิธีแก้ไขเบื้องต้น |

| Traffic ลดลงแบบฉับพลัน | เนื้อหาถูกมองว่าไม่มีคุณค่าใหม่ (Low Value) | เติม Case Study หรือมุมมองเฉพาะตัวลงในบทความ |

| หน้าใหม่ไม่ถูก Index | โครงสร้างเว็บดูเหมือนฟาร์มคอนเทนต์ | ปรับปรุง Technical Structure และลดความถี่การโพสต์ที่เน้นแต่ปริมาณ |

| CTR ต่ำแม้จะอยู่อันดับต้นๆ | พาดหัวและเนื้อหาดูเป็นหุ่นยนต์เกินไป | ปรับโทนการเขียนให้เป็นกันเองและตรงประเด็นมากขึ้น |

การสังเกตสัญญาณเหล่านี้และรีบปรับปรุงเนื้อหาให้มีความเป็นมนุษย์มากขึ้นจะช่วยรักษาความน่าเชื่อถือของโดเมนไว้ได้ ซึ่งการปรับตัวนี้เองจะเป็นก้าวสำคัญที่นำไปสู่หัวใจสำคัญที่แยกคอนเทนต์คุณภาพออกจากสแปมอย่างเด็ดขาด

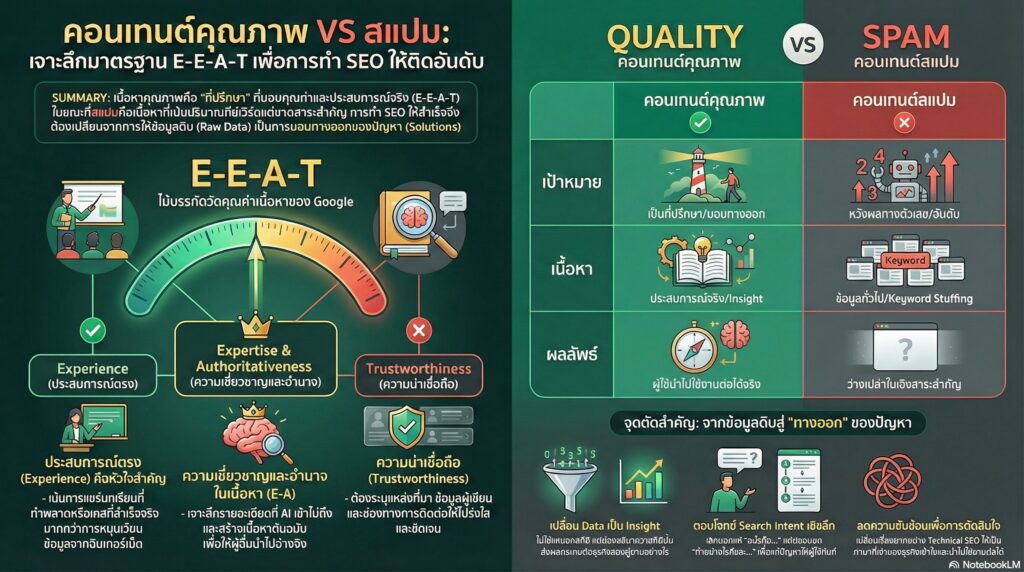

หัวใจสำคัญที่แยกคอนเทนต์คุณภาพออกจากสแปม

ความแตกต่างที่ชัดเจนที่สุดระหว่างคอนเทนต์คุณภาพและสแปมคือการมอบคุณค่าที่นำไปใช้งานต่อได้จริง(able Value) ไม่ใช่เพียงการมีคีย์เวิร์ดครบตามสูตร คอนเทนต์คุณภาพต้องทำหน้าที่เป็นที่ปรึกษาที่เข้าใจปัญหาของผู้ใช้อย่างแท้จริง ในขณะที่สแปมคือเนื้อหาที่ผลิตออกมาจำนวนมากเพื่อหวังผลทางตัวเลขแต่กลับว่างเปล่าในเชิงสาระสำคัญ

หลักการ E-E-A-T มาตรฐานตัดสินคุณค่าเนื้อหาของ Google

Google ใช้หลักการ E-E-A-T เป็นไม้บรรทัดวัดว่าเนื้อหาใดควรค่าแก่การอยู่อันดับบนสุด จากประสบการณ์ที่ผมเริ่มทำ SEO ตั้งแต่ปี 2558 บทเรียนสำคัญที่พบคือเนื้อหาที่ขาดประสบการณ์จริงมักจะสอบตกเพราะอัลกอริทึมในปัจจุบันสามารถแยกแยะได้ว่าเนื้อหานั้นเขียนขึ้นจากข้อมูลที่หมุนเวียนอยู่ในอินเทอร์เน็ต หรือเขียนขึ้นจากคนที่เคยลงมือทำจริง

| องค์ประกอบ | สิ่งที่ Google มองหา | วิธีปรับใช้ให้เหนือกว่าสแปม |

| Experience | หลักฐานการลงมือทำจริง (First-hand experience) | แชร์บทเรียนที่เคยทำพลาด หรือเคสที่เคยทำสำเร็จ เช่น การปรับโครงสร้าง Technical จนเพิ่ม Traffic ได้จริง |

| Expertise | ความเชี่ยวชาญในหัวข้อนั้นๆ | เจาะลึกรายละเอียดที่ AI ทั่วไปเข้าไม่ถึง เช่น เทคนิคเฉพาะทางใน Ecommerce SEO |

| Authoritativeness | การยอมรับจากภายนอกและการอ้างอิง | สร้างเนื้อหาที่เป็นต้นฉบับจนผู้อื่นนำไปอ้างอิงหรือแชร์ต่อ |

| Trustworthiness | ความน่าเชื่อถือและความโปร่งใส | ระบุแหล่งที่มา ข้อมูลผู้เขียน และช่องทางการติดต่อที่ชัดเจน |

การสร้างความน่าเชื่อถือไม่ได้เกิดจากการประกาศว่าเราเก่ง แต่เกิดจากการแสดงหลักฐานให้เห็น เช่น ในช่วงที่ผมรับงานกู้วิกฤตเว็บไซต์ที่ Traffic หายไปเกือบทั้งหมด สิ่งที่ช่วยให้เว็บกลับมาได้ไม่เพียงแต่การแก้โค้ด แต่คือการเติมประสบการณ์จริงลงไปในเนื้อหาเพื่อให้ Google มั่นใจว่าข้อมูลนี้เชื่อถือได้จริง

อ่านต่อบทความที่เกี่ยวข้อง ยกระดับเว็บไซต์ด้วยกลยุทธ์ SEO คุณภาพ

จุดตัดสำคัญระหว่างข้อมูลดิบกับคำตอบที่ผู้ใช้ต้องการจริง

คอนเทนต์ที่เป็นสแปมมักจะหยุดอยู่แค่การให้ข้อมูลพื้นฐาน(Raw Data) ที่หาได้ทั่วไป แต่คอนเทนต์คุณภาพจะเปลี่ยนข้อมูลเหล่านั้นให้กลายเป็นทางออกของปัญหา(Solutions) ผู้ใช้ไม่ได้ต้องการรู้แค่ว่า SEO คืออะไร แต่เขาต้องการรู้ว่าจะทำอย่างไรให้ยอดขายในเว็บ WordPress เพิ่มขึ้นการตอบโจทย์ความต้องการเชิงลึก (Search Intent) จึงเป็นจุดแบ่งเขตที่ชัดเจน

- เปลี่ยน Data เป็น Insight: แทนที่จะบอกแค่สถิติ ให้บอกว่าสถิตินั้นส่งผลกระทบต่อธุรกิจของผู้อ่านอย่างไร

- เน้นผลลัพธ์ที่จับต้องได้: จากเส้นทางที่ผมปั้นตัวเองจากคนธรรมดาสู่ Freelance จนเปิดบริษัท ผมพบว่าลูกค้าไม่ได้ซื้อคอนเทนต์เพราะมันยาว แต่ซื้อเพราะมันช่วยแก้ปัญหาให้เขาได้ทันที

- ลดความซับซ้อน: หน้าที่ของที่ปรึกษาที่ดีคือการทำให้เรื่องยากอย่าง Technical SEO กลายเป็นเรื่องที่เจ้าของธุรกิจเข้าใจและตัดสินใจต่อได้

เมื่อเราเข้าใจแล้วว่าคุณภาพวัดกันที่ความลึกของประสบการณ์และการตอบโจทย์ผู้ใช้ ขั้นตอนต่อไปคือการนำเครื่องมืออย่าง AI มาช่วยทุ่นแรงโดยไม่ให้เสียจิตวิญญาณของคอนเทนต์คุณภาพไป ซึ่งคุณสามารถเริ่มทำได้ทันทีผ่าน 6 ขั้นตอนปรับแต่ง AI Content ให้ปลอดภัยและติดอันดับ

6 ขั้นตอนปรับแต่ง AI Content ให้ปลอดภัยและติดอันดับ

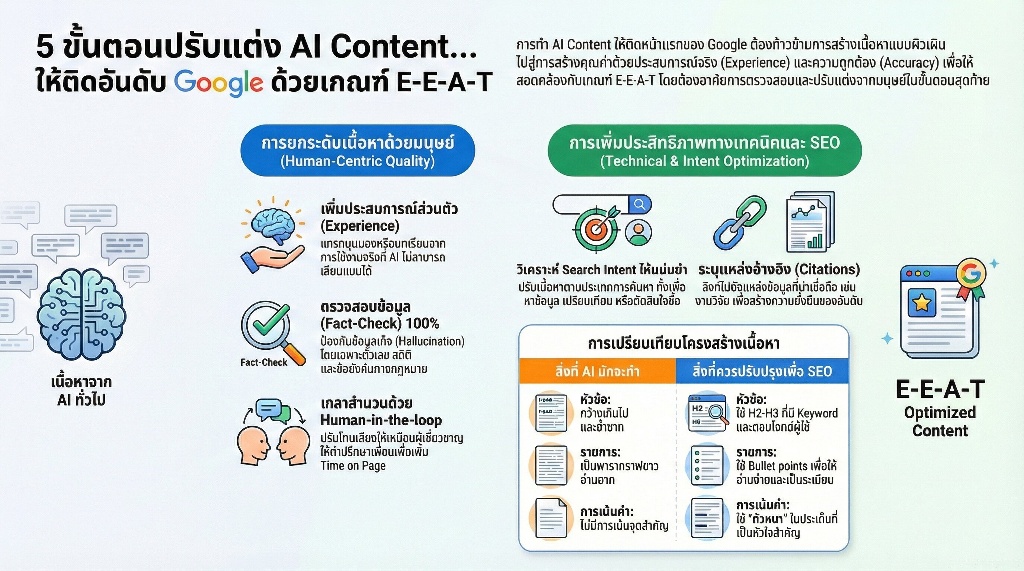

การทำ AI Content ให้รอดพ้นจากการถูกลดอันดับและขึ้นสู่หน้าแรกของ Google คือการเปลี่ยนจากเนื้อหาที่สร้างโดย Aiให้กลายเป็นคำแนะนำที่มีคุณค่าจากประสบการณ์จริงโดยเน้นความถูกต้องของข้อมูล (Accuracy) และความลึกซึ้งของเนื้อหาที่ AI ทั่วไปเลียนแบบไม่ได้ เพื่อให้สอดคล้องกับเกณฑ์ E-E-A-T ของ Google อย่างแท้จริง

การเพิ่มประสบการณ์ส่วนตัว (Experience) ลงในเนื้อหา

Google ให้ความสำคัญกับประสบการณ์ตรง (Experience) เพราะเป็นสิ่งที่ AI ไม่สามารถสัมผัสได้เอง การแทรกมุมมองส่วนตัวหรือบทเรียนที่เคยพบเจอจะช่วยให้เนื้อหามีความเฉพาะตัวสูงขึ้น ตัวอย่างเช่น ในการทำ SEO สำหรับเว็บ E-commerce เราพบว่าการระบุความรู้สึกจากการใช้งานสินค้าจริง หรือการบอกเล่าปัญหาที่เกิดขึ้นระหว่างการทดสอบ ช่วยให้บทความมีความน่าเชื่อถือและดึงดูดผู้ใช้งานได้มากกว่าการใช้คำบรรยายสรรพคุณที่ AI เจนเนอเรตออกมาแบบราบเรียบ

ลองเปลี่ยนจากการบอกว่าสินค้านี้ดีอย่างไรเป็นการเล่าว่าตอนที่เรานำสินค้านี้ไปใช้ในสถานการณ์จริง เราเจออุปสรรคอะไรและแก้ได้อย่างไรวิธีนี้ไม่เพียงแต่ทำให้ Google มองว่าเป็นเนื้อหาต้นฉบับ (Original Content) แต่ยังช่วยสร้างความสัมพันธ์ที่ดีกับผู้อ่านที่กำลังมองหาทางออกของปัญหาจริงๆ

เทคนิค Fact-Check ข้อมูลเพื่อป้องกันความผิดพลาดของ AI

ความถูกต้องของข้อมูลคือเกราะป้องกันที่สำคัญที่สุด เพราะ AI มักจะสร้างข้อมูลเท็จที่ดูเหมือนจริง (Hallucination) ขึ้นมาได้ทุกเมื่อ การตรวจสอบข้อมูล (Fact-check) จึงเป็นขั้นตอนที่ข้ามไม่ได้ โดยเฉพาะข้อมูลด้านตัวเลข สถิติ หรือข้อบังคับทางกฎหมาย

จากประสบการณ์ที่ WarriorSEO เคยรับงานกู้วิกฤตเว็บไซต์ที่ Traffic หายไปเกือบทั้งหมด สาเหตุส่วนใหญ่มาจากการปล่อยเนื้อหาที่มีข้อมูลคลาดเคลื่อนจนสูญเสียความเชื่อถือจากทั้งระบบและผู้ใช้งาน การจัดทำตารางตรวจสอบข้อมูลสำคัญก่อนเผยแพร่จึงเป็นแนวทางที่ช่วยรักษาคุณภาพเว็บไซต์ได้ยั่งยืนที่สุด

การปรับโครงสร้างบทความให้อ่านง่ายและเป็นระบบ (Formatting)

โครงสร้างบทความที่ดีช่วยให้ทั้งผู้ใช้งานสแกนอ่านข้อมูลได้รวดเร็วและ Google Bot เข้าใจบริบทของเนื้อหาได้แม่นยำขึ้น การใช้ Formatting ที่หลากหลายจะช่วยลดความน่าเบื่อของเนื้อหาที่ยาวเกินไป

| องค์ประกอบ | สิ่งที่ AI มักจะทำ | สิ่งที่ควรปรับปรุงเพื่อ SEO |

| หัวข้อ (Headings) | กว้างเกินไปและซ้ำซาก | ใช้ H2-H3 ที่มี Keyword และตอบคำถามผู้ใช้ |

| การเน้นคำ | ไม่มีการเน้นจุดสำคัญ | ใช้ ตัวหนา ในประเด็นที่เป็นหัวใจสำคัญ |

| รายการ (Lists) | เป็นพารากราฟยาวๆ | ใช้ Bullet points เพื่อให้อ่านง่ายและเป็นระเบียบ |

การใช้ Human-in-the-loop เพื่อเกลาสำนวนให้มีความเป็นมนุษย์

สำนวนภาษาที่ลื่นไหลและมีอารมณ์ความรู้สึกคือสิ่งที่แยกบทความชั้นดีออกจากบทความขยะการใช้กระบวนการ Human-in-the-loop หรือการให้คนเข้ามาปรับปรุงเนื้อหาในขั้นตอนสุดท้าย จะช่วยตัดคำเชื่อมที่ฟุ่มเฟือยและปรับโทนเสียงให้เข้ากับกลุ่มเป้าหมายได้ดีขึ้น

การปรับโทนให้เหมือนการปรึกษาเพื่อนหรือผู้เชี่ยวชาญที่พร้อมส่งมอบข้อมูลที่ถูกต้อง จะช่วยเพิ่มระยะเวลาที่ผู้อ่านอยู่บนหน้าเว็บ (Time on Page) ได้

การวิเคราะห์ Search Intent เพื่อตอบโจทย์ผู้ค้นหาอย่างแม่นยำ

AI อาจจะเขียนเนื้อหาได้ยาว แต่ถ้าเนื้อหานั้นไม่ตอบโจทย์ความต้องการของผู้ค้นหา (Search Intent) อันดับก็จะไม่มีทางขยับขึ้น การวิเคราะห์ว่า Keyword นั้นๆ ผู้ใช้ต้องการ ‘ข้อมูลความรู้’ ‘การเปรียบเทียบ’ หรือ ‘การตัดสินใจซื้อ’ คือหัวใจสำคัญของการทำ Content ให้ติดหน้า 1

- Informational Intent: เน้นการให้ความรู้เชิงลึกและคำแนะนำที่นำไปใช้ได้จริง

- Commercial Intent: เน้นการเปรียบเทียบข้อดี-ข้อเสีย เพื่อช่วยในการตัดสินใจ

- Transal Intent: เน้นความสะดวกในการเข้าถึงบริการหรือการสั่งซื้อ

การระบุแหล่งอ้างอิงที่น่าเชื่อถือเพื่อเพิ่มน้ำหนักให้ข้อมูล

การอ้างอิงแหล่งที่มา (Citations) คือการแสดงความโปร่งใสและเพิ่มความน่าเชื่อถือ (Trustworthiness) ให้กับเว็บไซต์ ตลอดระยะเวลากว่า 10 ปีที่เราปั้นเว็บไซต์จากศูนย์จนประสบความสำเร็จ เราพบว่าบทความที่มีการลิงก์ไปยังแหล่งข้อมูลอ้างอิงที่น่าเชื่อถือ เช่น งานวิจัย เว็บไซต์ภาครัฐ หรือบทความวิชาการ มักจะมีความยั่งยืนในอันดับและไม่ค่อยได้รับผลกระทบจากการอัปเดตอัลกอริทึมใหญ่ๆ

การระบุแหล่งที่มาอย่างชัดเจนไม่เพียงแต่เสริมสร้างความมั่นใจให้ผู้อ่าน แต่ยังเป็นการสร้างเครือข่ายความน่าเชื่อถือในสายตาของ Search Engine ซึ่งเป็นรากฐานสำคัญของความสำเร็จที่ยั่งยืนในยุคที่ Google และ AI ทำงานร่วมกันอย่างใกล้ชิด

ความสำเร็จที่ยั่งยืนในยุคที่ Google และ AI ทำงานร่วมกัน

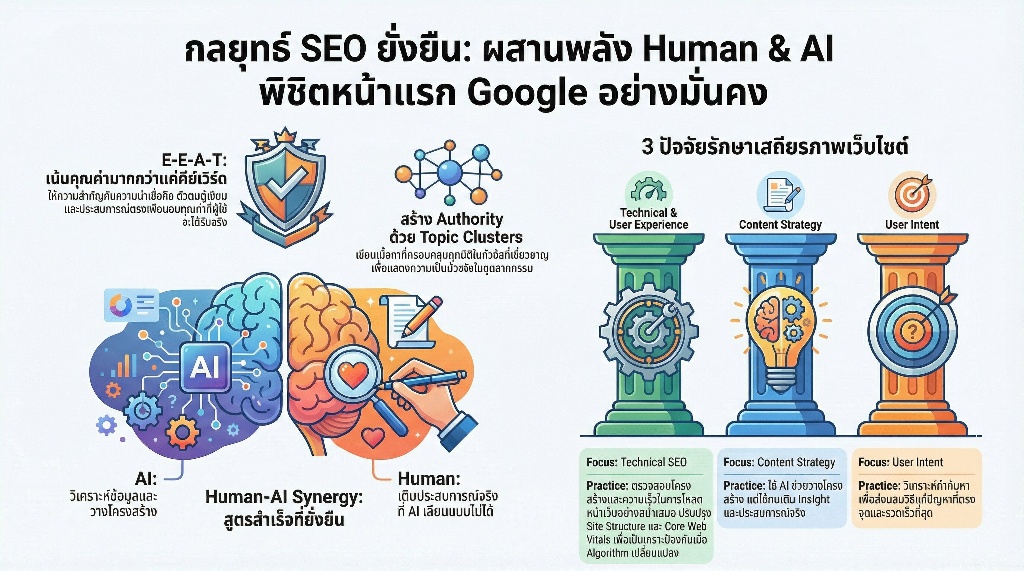

การอยู่รอดในยุคนี้ไม่ใช่การเลือกระหว่างคนหรือAIแต่คือการใช้ AI เป็นเครื่องทุ่นแรงในการวิเคราะห์ข้อมูล ในขณะที่มนุษย์ทำหน้าที่มอบประสบการณ์จริง(First-hand Experience) ที่ AI เลียนแบบไม่ได้ เพื่อตอบโจทย์เกณฑ์ E-E-A-T ของ Google ที่ให้ความสำคัญกับความน่าเชื่อถือและคุณค่าที่ผู้ใช้จะได้รับจริงมากกว่าแค่การมีคีย์เวิร์ดในหน้ากระดาษ

การสร้าง Authority ของเว็บไซต์ให้แข็งแกร่งในระยะยาว

Authority เกิดจากการสะสมความน่าเชื่อถือผ่านข้อมูลที่ถูกต้องและตรวจสอบได้จริง ตลอดระยะเวลากว่า 10 ปีที่ผมคลุกคลีกับการปั้นเว็บไซต์ตั้งแต่สมัยเริ่มต้นเป็น Freelance จนถึงการบริหารงานในรูปแบบบริษัท บทเรียนสำคัญคือ Google มักจะเลือกให้ความสำคัญกับตัวตนของผู้ให้ข้อมูล มากกว่าแค่ปริมาณบทความ การระบุชื่อผู้เขียนที่มีความเชี่ยวชาญเฉพาะทางและการอ้างอิงแหล่งที่มาที่ชัดเจนจึงเป็นรากฐานที่ขาดไม่ได้ในการสร้างความเชื่อมั่นให้ทั้ง Search Engine และผู้ใช้งาน

เพื่อให้เว็บไซต์มี Authority ที่มั่นคง คุณควรเน้นการสร้าง Topic Clusters หรือการเขียนเนื้อหาที่ครอบคลุมทุกมิติของหัวข้อนั้นๆ แทนการเขียนเรื่องทั่วไปแบบกว้างๆ การทำแบบนี้ไม่เพียงแต่ช่วยให้ Google เข้าใจโครงสร้างเว็บไซต์ได้ง่ายขึ้น แต่ยังทำให้ผู้ใช้งานมองว่าคุณคือที่ปรึกษาที่เป็นตัวจริงในอุตสาหกรรมนั้น ซึ่งเป็นปัจจัยหลักที่ช่วยให้เว็บขายสินค้าติดหน้า 1 Google ได้ยาวนาน

การเติบโตแบบก้าวกระโดดโดยไม่ต้องกลัว Algorithm เปลี่ยนแปลง

การปรับปรุงโครงสร้างทางเทคนิค (Technical Structure) ควบคู่กับการมอบคุณค่าในเนื้อหา คือเกราะป้องกันที่ดีที่สุดเมื่อมีการอัปเดต Algorithm จากประสบการณ์ที่ผมเคยเข้าไปช่วยกู้วิกฤตเว็บไซต์ที่ Traffic หายไปเกือบทั้งหมด สาเหตุส่วนใหญ่มักเกิดจากการมองข้ามพื้นฐานด้าน User Experience และการทำ Content ที่เน้นปริมาณจนขาดคุณภาพ การกลับไปแก้ไขที่ต้นเหตุด้วยการปรับปรุงโครงสร้างเว็บไซต์ให้รองรับ Core Web Vitals และการจัดระเบียบเนื้อหาให้ตรงกับ User Intent จะช่วยให้เว็บไซต์ฟื้นตัวและเติบโตได้อย่างมั่นคงในระยะยาว

ผลลัพธ์ของการทำ SEO ที่ถูกต้องจะแสดงผลผ่าน Organic Traffic ที่เพิ่มขึ้นอย่างต่อเนื่องแม้ในช่วงที่ Google มีการปรับเปลี่ยนกฎเกณฑ์ครั้งใหญ่ โดยคุณสามารถใช้แนวทางปฏิบัติดังนี้เพื่อรักษาเสถียรภาพของเว็บไซต์

| จุดที่ต้องโฟกัส | แนวทางปฏิบัติเพื่อความยั่งยืน |

| Technical SEO | ตรวจสอบ Site Structure และความเร็วในการโหลดหน้าเว็บอย่างสม่ำเสมอ |

| Content Strategy | ใช้ AI ช่วยวางโครงสร้าง แต่ต้องใช้คนเติมInsightและประสบการณ์จริงลงไป |

| User Intent | วิเคราะห์คำค้นหาเพื่อส่งมอบวิธีแก้ปัญหาที่ตรงจุดและรวดเร็วที่สุด |

เมื่อเข้าใจหลักการสร้างความยั่งยืนผ่านการผสานพลังระหว่างเทคโนโลยีและความเชี่ยวชาญของมนุษย์แล้ว ขั้นตอนต่อไปที่สำคัญไม่แพ้กันคือการทำความเข้าใจข้อกำหนดที่เข้มงวดของ Google เพื่อให้มั่นใจว่าการนำ AI มาใช้งานในกระบวนการสร้างเนื้อหาของคุณจะไม่ส่งผลกระทบเชิงลบต่ออันดับในอนาคต

Google แบนเนื้อหาที่เขียนด้วย AI หรือไม่?

Google ไม่ได้แบนเนื้อหาที่สร้างโดย AI โดยตรง แต่จะให้ความสำคัญกับคุณภาพของเนื้อหาเป็นหลัก หากบทความนั้นมีประโยชน์ ตอบโจทย์ผู้ค้นหา และมีคุณค่าตามหลัก E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) ก็มีโอกาสติดอันดับที่ดีได้เช่นเดียวกับเนื้อหาที่มนุษย์เขียน

จะทำอย่างไรไม่ให้ AI Content ถูกมองว่าเป็นสแปม?

กุญแจสำคัญคือการหลีกเลี่ยงการปั๊มเนื้อหาปริมาณมาก (Mass Production) โดยไม่มีการตรวจสอบ คุณควรใช้กระบวนการ Human-in-the-loop เพื่อปรับแต่งสำนวน เพิ่มประสบการณ์ส่วนตัว ตรวจสอบความถูกต้องของข้อมูล (Fact-check) และจัดโครงสร้างให้อ่านง่าย เพื่อให้เนื้อหาดูเป็นธรรมชาติและมอบคุณค่าที่แท้จริงแก่ผู้อ่าน

การทำ AI Content ให้ติดอันดับอย่างยั่งยืนมีความท้าทายอย่างไร?

ความท้าทายที่ยิ่งใหญ่ที่สุดคือการรักษาความน่าเชื่อถือและการปรับตัวตามอัลกอริทึมของ Google ที่มีการอัปเดตอยู่เสมอ โดยเฉพาะการแยกแยะระหว่างข้อมูลดิบจาก AI กับคำตอบที่ผู้ใช้ต้องการจริงๆ การปรับแต่งเนื้อหาให้ตรงกับ Search Intent จึงเป็นสิ่งที่ขาดไม่ได้ในการทำ SEO ยุคใหม่

หากต้องการประยุกต์ใช้ AI SEO ให้เห็นผลลัพธ์จริงในเชิงธุรกิจ ควรเริ่มต้นอย่างไร?

WarriorSEO ให้บริการที่ปรึกษาและรับทำ SEO ครบวงจร โดยใช้กลยุทธ์จากประสบการณ์จริงในการทำเว็บไซต์ธุรกิจจนประสบความสำเร็จ เราเชี่ยวชาญด้าน AI SEO, GEO, WordPress และ Ecommerce SEO ครอบคลุมทั้ง Technical, On-page และ Off-page นอกจากนี้ยังมีคอร์สเรียนและบริการ In-house Training เพื่อช่วยให้ธุรกิจเติบโตอย่างยั่งยืนและรับมือกับการเปลี่ยนแปลงของอัลกอริทึมได้ทันท่วงที