การทำ SEO ในยุค AI ต้องให้ความสำคัญกับการปรับโครงสร้างเว็บไซต์ (Technical Structure) ให้เป็นระบบ โดยใช้ Schema Markup และการจัดลำดับชั้นข้อมูลที่ชัดเจน เพื่อให้ AI สามารถเข้าถึงและประมวลผลเนื้อหาได้ถูกต้อง ซึ่งจะช่วยเพิ่มโอกาสในการถูกเลือกไปแสดงผลในคำตอบของ AI

ในบทความนี้ ผมตั้งใจจะแบ่งปันแนวทางที่ผมได้ลองปรับจูนมาแล้วว่าได้ผลจริง โดยเราจะไล่เรียงกันไปตั้งแต่การวางรากฐานของ Semantic HTML เพื่อช่วยให้ AI แยกแยะส่วนประกอบของหน้าเว็บได้แม่นยำ, การทำโครงสร้าง Internal Link ที่เน้นความสัมพันธ์ของเนื้อหา (Topic Clusters) มากกว่าแค่ปริมาณ ไปจนถึงการปรับเทคนิคด้านความเร็วและความเสถียรที่ส่งผลต่อความน่าเชื่อถือ เพื่อให้ทุกท่านได้เห็นRoadmapและนำเช็คลิสต์เหล่านี้ไปปรับปรุงเว็บไซต์ของตัวเองให้พร้อมรับมือกับความเปลี่ยนแปลงได้ทันทีครับ

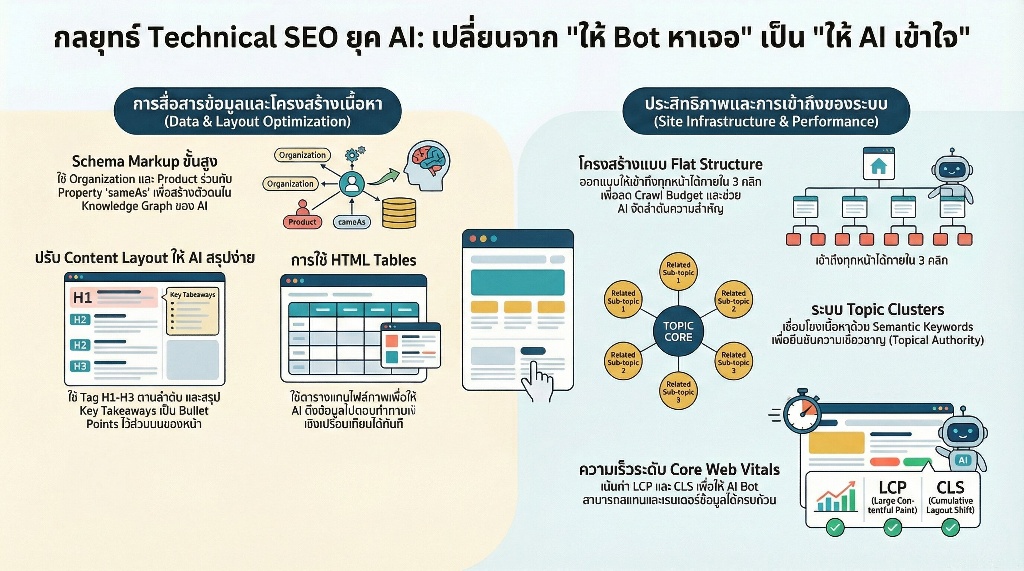

สรุปประเด็นสำคัญจากกลยุทธ์ปรับแต่งเว็บไซต์เพื่อครองพื้นที่บน AI Search

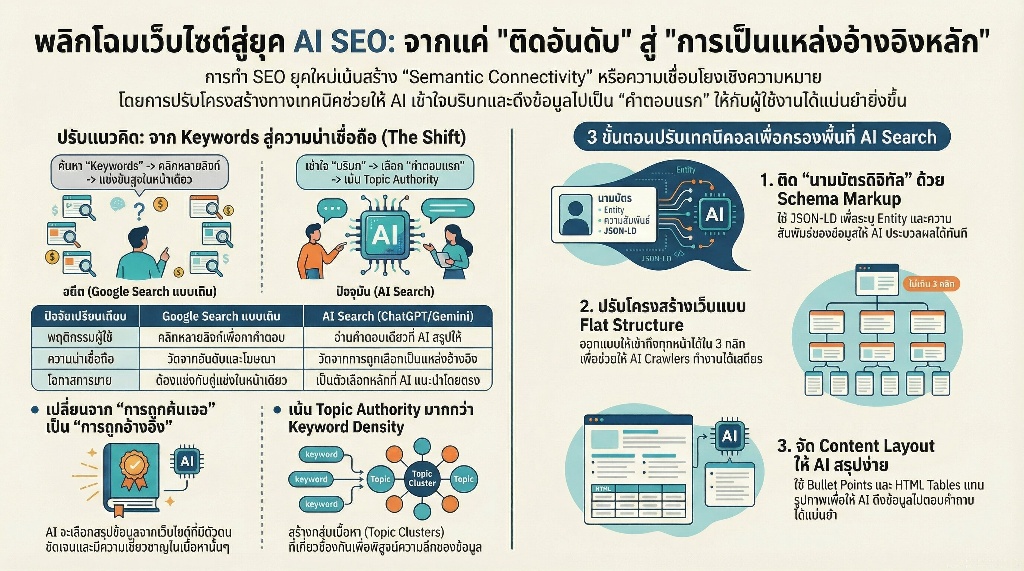

- การยกระดับเว็บไซต์จากการติดอันดับ Google แบบเดิม สู่การเป็นแหล่งข้อมูลอ้างอิงหลักที่ AI อย่าง ChatGPT และ Gemini เลือกแนะนำ เพื่อสร้างผลลัพธ์การเข้าถึงที่มีประสิทธิภาพสูงกว่าเดิม

- หัวใจสำคัญคือการสร้าง Semantic Connectivity โดยเปลี่ยนหน้าเว็บให้เป็นฐานข้อมูลความรู้ที่เชื่อมโยงบริบทเชิงลึก ช่วยทลายกำแพงระหว่างภาษาคนกับโมเดล AI และเพิ่มความน่าเชื่อถือให้ข้อมูล

- การปรับโครงสร้างเทคนิคอลเพื่อ AI Crawlers โดยเฉพาะ เช่น การใช้ Schema Markup ขั้นสูง, การปรับ Site Architecture เป็นแบบ Flat Structure และการจัดการ Content Layout ให้ AI สรุปข้อมูลได้แม่นยำ

- การสร้างความสำเร็จที่ยั่งยืนผ่านการสะสม Authority เพื่อให้แบรนด์กลายเป็นแหล่งอ้างอิงหลักของ AI ซึ่งจะช่วยดึงดูดทราฟฟิกคุณภาพสูงและสร้างการเติบโตแบบทวีคูณในยุค Generative Search

Table of Contents

เปลี่ยนเว็บไซต์ให้เป็นคำตอบแรกที่ AI เลือกแนะนำ

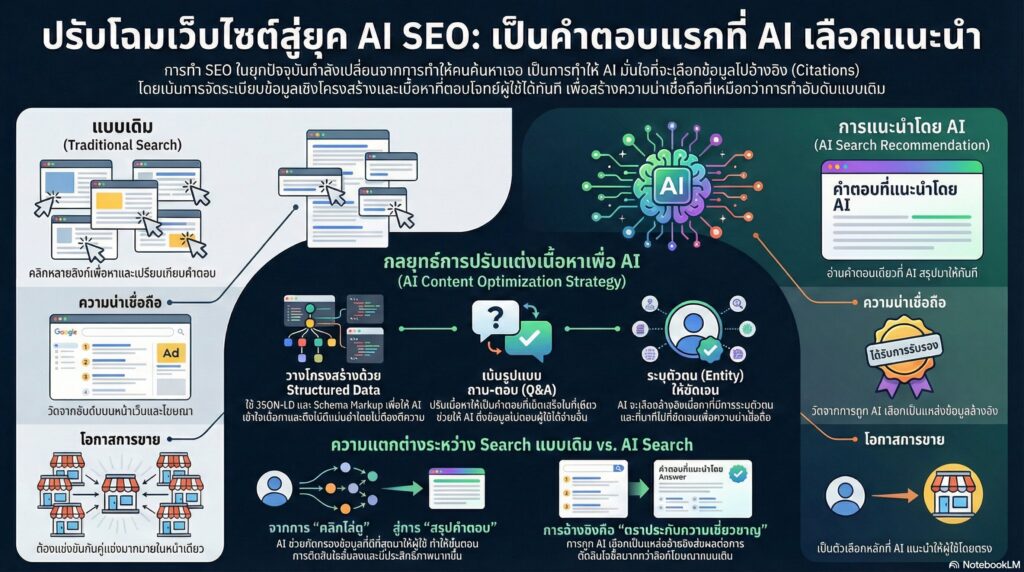

การทำให้ AI เลือกแนะนำเว็บไซต์ของคุณคือการเปลี่ยนจากการทำเพื่อให้คนค้นหาเจอเป็นการทำเพื่อให้ AI มั่นใจที่จะอ้างอิงโดยเน้นการจัดระเบียบข้อมูลเชิงโครงสร้าง (Structured Data) ที่สมบูรณ์และเนื้อหาที่ตอบโจทย์ความต้องการของผู้ใช้ได้อย่างเบ็ดเสร็จในที่เดียว

พลังของการเป็นแหล่งข้อมูลอ้างอิงบน ChatGPT และ Gemini

AI ยุคใหม่ให้ความสำคัญกับ ‘ความน่าเชื่อถือ’ ผ่านการระบุแหล่งที่มา (Citations) การที่เว็บไซต์ถูกเลือกไปแสดงผลในคำตอบของ ChatGPT หรือ Gemini ไม่เพียงแค่สร้างการรับรู้ แต่เป็นการประทับตราความเชี่ยวชาญให้กับแบรนด์โดยอัตโนมัติ ซึ่งมีผลต่อการตัดสินใจซื้อมากกว่าการเห็นลิงก์โฆษณาแบบเดิม

จากการสังเกตข้อมูลหลังบ้านในหลายโปรเจกต์ บทเรียนสำคัญคือ AI จะเลือกอ้างอิงเนื้อหาที่มีการระบุตัวตน (Entity) ชัดเจน การปรับเนื้อหาให้เป็นรูปแบบถาม-ตอบ (Q&A) พร้อมระบุ Schema Markup ที่ถูกต้อง ช่วยลดขั้นตอนที่ AI ต้องตีความ ทำให้ข้อมูลถูกดึงไปใช้เป็นคำตอบแรกได้แม่นยำขึ้น

ผลลัพธ์ที่เหนือกว่าการติดอันดับ Google แบบเดิม

การเป็นคำตอบแรกของ AI ช่วยลดขั้นตอนการตัดสินใจของผู้ใช้งาน เพราะ AI ได้ทำการ ‘คัดกรอง’ ข้อมูลที่ดีที่สุดมาให้แล้ว ต่างจากการค้นหาแบบเดิมที่ผู้ใช้ต้องไล่คลิกทีละลิงก์เพื่อเปรียบเทียบข้อมูลด้วยตัวเอง

| ปัจจัยเปรียบเทียบ | Google Search แบบเดิม | การแนะนำโดย AI (AI Search) |

| พฤติกรรมผู้ใช้ | คลิกหลายลิงก์เพื่อหาคำตอบ | อ่านคำตอบเดียวที่ AI สรุปให้ |

| ความน่าเชื่อถือ | วัดจากอันดับและโฆษณา | วัดจากการถูกเลือกเป็นแหล่งอ้างอิง |

| โอกาสการขาย | ต้องแข่งกับคู่แข่งในหน้าเดียวกัน | เป็นตัวเลือกหลักที่ AI แนะนำโดยตรง |

การปรับตัวเข้าสู่ยุค AI SEO จึงเป็นการลงทุนที่ให้ผลลัพธ์ยั่งยืนกว่า เพราะเป็นการสร้างรากฐานความน่าเชื่อถือในระดับที่ Machine Learning ยอมรับ แต่ความพยายามทั้งหมดอาจไร้ผล หากเว็บไซต์ยังมีปัญหาเชิงเทคนิคที่มองไม่เห็นซึ่งคอยขัดขวางไม่ให้ AI เข้าถึงข้อมูลสำคัญเหล่านี้ได้

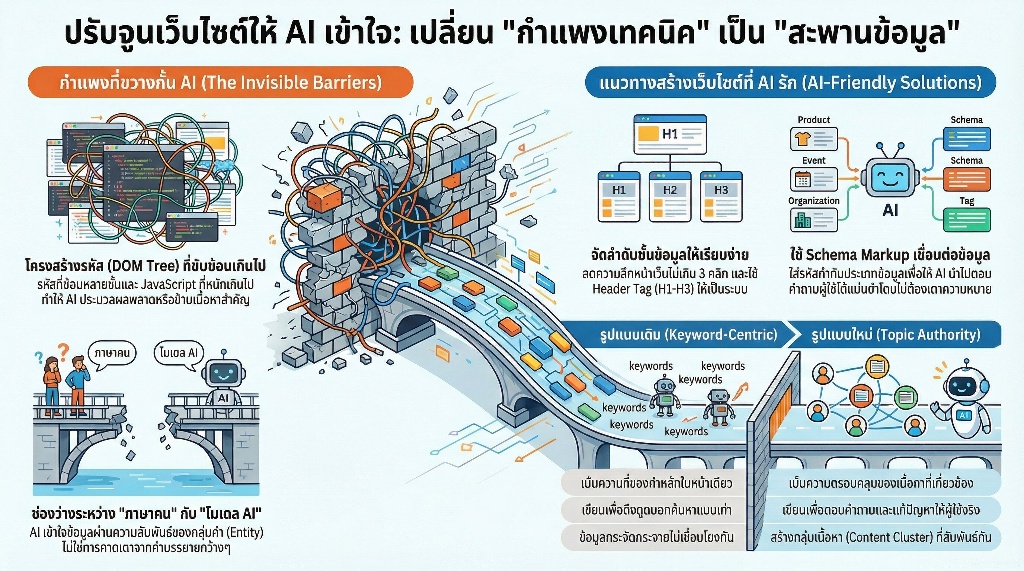

ปัญหาที่มองไม่เห็นซึ่งขัดขวางไม่ให้ AI เข้าถึงข้อมูล

AI ไม่สามารถดึงข้อมูลไปใช้ได้อย่างเต็มประสิทธิภาพหากเว็บไซต์มีกำแพงทางเทคนิคที่ซับซ้อนและข้อมูลขาดความเชื่อมโยงเชิงความหมาย (Semantic Context) แม้หน้าเว็บจะดูสวยงามสำหรับมนุษย์ แต่สำหรับบอทประมวลผลของ AI มันอาจเป็นเพียงชุดรหัสที่สับสนจนไม่สามารถระบุได้ว่าเนื้อหานั้นตอบโจทย์ผู้ใช้จริงหรือไม่ การปรับจูนโครงสร้างจึงเป็นจุดเริ่มต้นที่สำคัญกว่าการเขียนเนื้อหาเพียงอย่างเดียว

โครงสร้างเว็บแบบเก่าที่ซับซ้อนจนบอทประมวลผลพลาด

การใช้รหัสโครงสร้าง (DOM Tree) ที่ซ้อนกันหลายชั้นเกินความจำเป็นทำให้บอทของ AI ใช้พลังงานในการประมวลผลสูงเกินไปจนอาจเลือกที่จะข้ามเนื้อหาสำคัญบางส่วนไป การออกแบบเว็บในยุคก่อนที่เน้นการตกแต่งด้วย JavaScript หนักๆ โดยไม่มีการทำ Server-Side Rendering (SSR) มักส่งผลให้ข้อมูลที่ AI เห็นเป็นเพียงหน้าว่างหรือโค้ดที่อ่านไม่ออก

แนวทางแก้ไขที่ได้ผลจริงคือการปรับปรุงลำดับชั้นของข้อมูลให้เรียบง่ายที่สุด จากประสบการณ์ที่เคยปรับปรุงโครงสร้างเว็บไซต์ขนาดใหญ่ พบว่าการลดความลึกของหน้าเว็บ (Click Depth) ให้ไม่เกิน 3 คลิกจากหน้าแรก และการจัดระเบียบ Header Tag (H1-H3) ให้เป็นระบบ ช่วยให้บอทสามารถทำดัชนีข้อมูลได้ครบถ้วนและรวดเร็วขึ้นอย่างเห็นได้ชัด

ช่องว่างระหว่างภาษาคนกับภาษาที่โมเดล AI เข้าใจ

มนุษย์สื่อสารด้วยบริบทและอารมณ์ แต่โมเดล AI ประมวลผลผ่านความสัมพันธ์ของกลุ่มคำและเอนทิตี(Entity) ที่ระบุตัวตนชัดเจน หากเนื้อหาเขียนด้วยภาษากลางๆ ที่กว้างจนเกินไป AI จะไม่สามารถเชื่อมโยงได้ว่าเนื้อหานั้นเกี่ยวข้องกับหัวข้อหลักอย่างไร การระบุคำเฉพาะเจาะจงที่แสดงถึงความเชี่ยวชาญในเรื่องนั้นๆ จึงเป็นสิ่งที่ขาดไม่ได้

การใช้ Schema Markup หรือข้อมูลโครงสร้างเป็นสะพานเชื่อมช่องว่างนี้ได้ดีที่สุด การใส่รหัสกำกับว่านี่คือชื่อบุคคลนี่คือราคาหรือนี่คือบทวิจารณ์ช่วยให้ AI ไม่ต้องเดาความหมายเอง การปรับเปลี่ยนเพียงเล็กน้อยในระดับรหัสหลังบ้านนี้ช่วยให้ AI นำข้อมูลไปตอบคำถามผู้ใช้ได้แม่นยำกว่าการเขียนคำบรรยายยาวๆ เพียงอย่างเดียว

ทำไมการเน้นแค่ Keywords เพียงอย่างเดียวถึงเริ่มไม่ได้ผล

อัลกอริทึมของ AI ในปัจจุบันก้าวข้ามการจับคู่คำ (Keyword Matching) ไปสู่การทำความเข้าใจความตั้งใจของผู้ค้นหา (Search Intent) เรียบร้อยแล้ว การพยายามแทรกคำค้นหาซ้ำๆ โดยไม่มีเนื้อหาที่สนับสนุนความหมายโดยรอบ ไม่เพียงแค่ทำให้ผู้อ่านรู้สึกอึดอัด แต่ยังทำให้ AI มองว่าเนื้อหานั้นมีคุณภาพต่ำและขาดความน่าเชื่อถือ

| รูปแบบเดิม (Keyword-Centric) | รูปแบบใหม่ (Topic Authority) |

| เน้นความถี่ของคำหลักในหน้าเดียว | เน้นความครอบคลุมของเนื้อหาที่เกี่ยวข้อง |

| เขียนเพื่อดึงดูดบอทค้นหาแบบเก่า | เขียนเพื่อตอบคำถามและแก้ปัญหาให้ผู้ใช้จริง |

| ข้อมูลกระจัดกระจายไม่เชื่อมโยงกัน | สร้างกลุ่มเนื้อหา (Content Cluster) ที่สัมพันธ์กัน |

บทเรียนสำคัญจากการทำงานด้านข้อมูลคือ การสร้างเนื้อหาที่ตอบโจทย์ทำไมและอย่างไรมีน้ำหนักมากกว่าการบอกว่าคืออะไรเพียงอย่างเดียว เมื่อเราสามารถพิสูจน์ได้ว่าเนื้อหาของเรามีความลึกและครบถ้วนในมิติที่ AI มองหา กุญแจสำคัญคือการสร้าง Semantic Connectivity เพื่อเชื่อมโยงทุกจุดเข้าด้วยกันอย่างเป็นระบบ

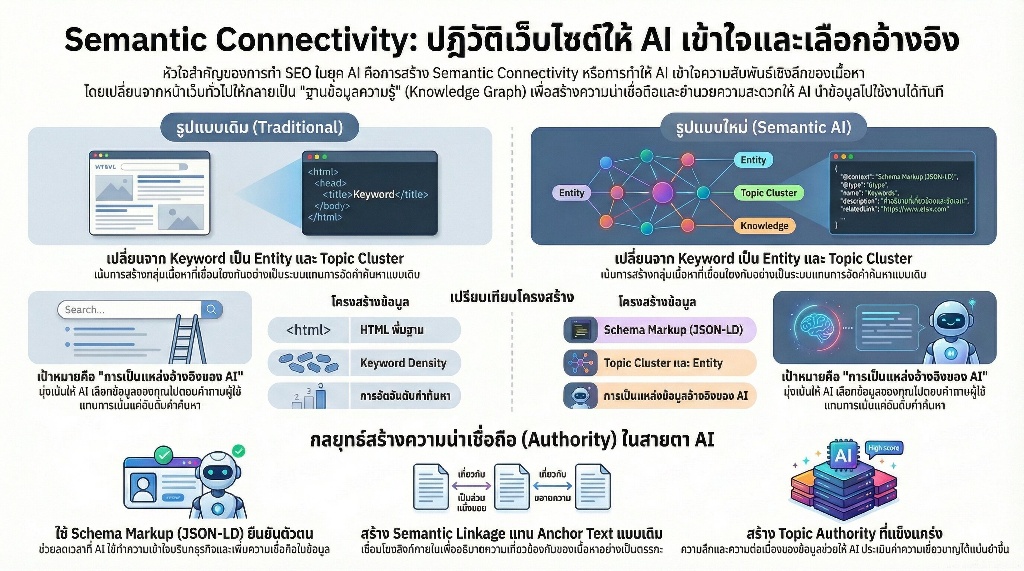

กุญแจสำคัญคือการสร้าง Semantic Connectivity

การสร้าง Semantic Connectivity คือการทำให้ AI เข้าใจความสัมพันธ์ระหว่างเนื้อหาบนเว็บไซต์ในระดับลึก เพื่อให้ระบบมองเห็นว่าข้อมูลแต่ละส่วนเชื่อมโยงกันเป็นโครงข่ายความรู้ที่สมบูรณ์ ไม่ใช่แค่ชุดคำค้นหาที่กระจัดกระจาย การปรับปรุงส่วนนี้ช่วยให้ AI Search Engine สามารถดึงข้อมูลไปตอบคำถามผู้ใช้ได้อย่างแม่นยำและเพิ่มโอกาสในการถูกเลือกเป็นแหล่งข้อมูลอ้างอิงหลัก

การเปลี่ยนจากหน้าเว็บทั่วไปให้กลายเป็นฐานข้อมูลความรู้

การปรับโครงสร้างข้อมูลให้เป็น Knowledge Graph คือหัวใจของการสื่อสารกับ AI โดยตรง การเปลี่ยนหน้าเว็บที่เน้นเพียงการอ่านด้วยตาให้กลายเป็นข้อมูลที่เครื่องจักรประมวลผลได้ (Machine-Readable) จะช่วยให้ AI ระบุได้ทันทีว่าเนื้อหาของคุณมีความสัมพันธ์กับหัวข้ออื่นอย่างไร

| องค์ประกอบ | รูปแบบเดิม (Traditional) | รูปแบบใหม่ (Semantic AI) |

| การจัดกลุ่มเนื้อหา | เน้น Keyword Density | เน้น Topic Cluster และ Entity |

| โครงสร้างข้อมูล | HTML พื้นฐาน | Schema Markup (JSON-LD) |

| เป้าหมาย | การจัดอันดับคำค้นหา | การเป็นแหล่งข้อมูลอ้างอิงของ AI |

จากบทเรียนที่ผมพบในการปรับปรุงระบบข้อมูล การทำ Schema Markup ไม่เพียงแค่เพิ่ม Rich Snippets แต่คือการสร้างข้อมูลยืนยันตัวตนให้กับเนื้อหา ซึ่งช่วยลดระยะเวลาที่ AI ใช้ในการทำความเข้าใจบริบทของธุรกิจลงได้อย่างมหาศาล และทำให้ระบบเชื่อถือข้อมูลที่นำเสนอมากขึ้น

หัวใจของการเชื่อมโยงบริบทเพื่อสร้างความน่าเชื่อถือให้ระบบ

ความน่าเชื่อถือของเว็บไซต์ในยุค AI วัดจากความลึกและความต่อเนื่องของข้อมูล การเชื่อมโยงลิงก์ภายใน (Internal Link) ต้องก้าวข้ามการใช้ Anchor Text แบบเดิมไปสู่การสร้าง Semantic Linkage ที่อธิบายความเกี่ยวข้องกันของเนื้อหาอย่างเป็นระบบ เพื่อสร้าง Topic Authority ที่แข็งแกร่งในสายตาของอัลกอริทึม

การวางโครงสร้างลิงก์ที่เน้นส่งมอบคุณค่าจะช่วยให้ AI มองเห็นว่าคุณคือตัวจริงในอุตสาหะนั้น [แนะนำลิงก์:Schema Markup สำหรับ AI SEOหัวข้อการเลือกประเภท Schema ที่เหมาะสมกับธุรกิจ] การเชื่อมโยงเนื้อหาที่เกี่ยวข้องกันในเชิงลึกช่วยให้ระบบประเมินค่าความเชี่ยวชาญ (Expertise) ได้แม่นยำกว่าการสร้างหน้าเว็บแยกส่วนกันโดยไม่มีความเกี่ยวข้องกันทางตรรกะ

เมื่อโครงสร้าง Semantic มั่นคงแล้ว ขั้นตอนถัดไปที่ต้องให้ความสำคัญคือการลงรายละเอียดในส่วนของขั้นตอนปรับโครงสร้างเทคนิคอลเพื่อครองพื้นที่ AI Searchเพื่อเปลี่ยนโครงสร้างความรู้ให้กลายเป็นการเติบโตที่จับต้องได้จริงบนหน้าผลการค้นหา

ขั้นตอนปรับโครงสร้างเทคนิคอลเพื่อครองพื้นที่ AI Search

การปรับโครงสร้างเทคนิคอลในยุค AI Search คือการเปลี่ยนจากการทำให้ Bot หาเจอเป็นการทำให้ AI เข้าใจบริบทเพื่อให้ระบบประมวลผลสามารถดึงข้อมูลไปตอบคำถามผู้ใช้ได้อย่างแม่นยำ การปรับแต่งที่เน้นความชัดเจนของข้อมูลเชิงโครงสร้างจะช่วยให้เว็บไซต์ของคุณกลายเป็นแหล่งอ้างอิงหลักที่ AI เลือกใช้ มากกว่าเพียงแค่การติดอันดับบนหน้าค้นหาแบบเดิม

การวาง Schema Markup ขั้นสูงเพื่อระบุตัวตนและประเภทธุรกิจ

Schema Markup เปรียบเสมือนนามบัตรดิจิทัลที่บอก AI ว่าเนื้อหาแต่ละส่วนคืออะไร การใช้ Schema ระดับสูงอย่าง Organization, Product, หรือ LocalBusiness ร่วมกับ PropertysameAsเพื่อเชื่อมโยงไปยังโซเชียลมีเดียหรือแหล่งอ้างอิงที่น่าเชื่อถือ จะช่วยสร้างความเชื่อมโยงของตัวตนแบรนด์ (Entity) ในระบบ Knowledge Graph ของ AI ได้อย่างแข็งแกร่ง

จากการทดลองปรับใช้ Schema ในกลุ่มธุรกิจบริการ พบว่าการระบุ Property อย่างareaServedและknowsAboutช่วยให้ AI ระบุความเชี่ยวชาญเฉพาะทางได้ชัดเจนขึ้น ส่งผลให้เมื่อมีการค้นหาเชิงเปรียบเทียบหรือค้นหาผู้เชี่ยวชาญในพื้นที่ AI จะดึงข้อมูลแบรนด์ไปนำเสนอเป็นลำดับต้นๆ เนื่องจากมีความชัดเจนของข้อมูลมากกว่าคู่แข่งที่ไม่ได้ระบุรายละเอียดเหล่านี้

ปรับปรุง Site Architecture ให้เป็นแบบ Flat Structure

โครงสร้างเว็บไซต์ที่ซับซ้อนและลึกเกินไปคืออุปสรรคใหญ่ของ AI Crawlers การปรับ Site Architecture ให้เป็นแบบ Flat Structure ที่ผู้ใช้และ Bot สามารถเข้าถึงเนื้อหาทุกหน้าได้ภายในไม่เกิน 3 คลิก จะช่วยลด Crawl Budget และทำให้ AI จัดลำดับความสำคัญของเนื้อหาได้ถูกต้อง การใช้หมวดหมู่ที่ชัดเจนและตัดหน้าเว็บที่ไม่จำเป็นออกจะช่วยให้น้ำหนักของความสำคัญกระจายไปยังหน้าหลักได้อย่างมีประสิทธิภาพ

ระบบ Internal Linking ที่เน้นความสัมพันธ์เชิงลึกของเนื้อหา

Internal Link ในยุค AI ไม่ได้มีหน้าที่แค่การส่งคนอ่านไปยังหน้าถัดไป แต่คือการสร้างแผนที่ความรู้(Topic Clusters) การเชื่อมโยงเนื้อหาควรใช้ Anchor Text ที่เป็น Semantic Keywords หรือคำที่มีความหมายเกี่ยวข้องกันเชิงบริบท เพื่อบอก AI ว่าบทความแต่ละชิ้นมีความสัมพันธ์กันอย่างไรในหัวข้อนั้นๆ

การจัดกลุ่มเนื้อหาที่เกี่ยวข้องกันและเชื่อมโยงกลับไปยังหน้าเสาหลัก (Pillar Page) จะช่วยยืนยันความเชี่ยวชาญในเนื้อหา (Topical Authority) ซึ่งเป็นปัจจัยสำคัญที่ AI ใช้พิจารณาความน่าเชื่อถือของข้อมูล

เพิ่มประสิทธิภาพความเร็วโหลดระดับ Core Web Vitals

ความเร็วในการโหลดหน้าเว็บมีผลโดยตรงต่อการที่ AI Bot จะสแกนข้อมูลได้ครบถ้วนหรือไม่ โดยเฉพาะค่า Largest Contentful Paint (LCP) และ Cumulative Layout Shift (CLS) เว็บไซต์ที่โหลดช้าหรือมีองค์ประกอบกระตุกขณะโหลดจะถูกมองว่ามีคุณภาพต่ำและอาจส่งผลให้ AI ดึงข้อมูลไปประมวลผลไม่สมบูรณ์ การบีบอัดรูปภาพและการจัดการ Render-blocking Resources จึงเป็นสิ่งที่ต้องทำทันทีเพื่อให้ระบบ AI เข้าถึงข้อมูลได้เสถียรที่สุด

การจัดการ Sitemap และ Robots.txt สำหรับ AI Crawlers โดยเฉพาะ

การสื่อสารกับ AI Bot ผ่าน Robots.txt ต้องมีความเฉพาะเจาะจงมากขึ้น คุณควรอนุญาตให้ AI Crawlers (เช่น GPTBot หรือ CCBot) เข้าถึงไฟล์ CSS และ JavaScript เพื่อให้ระบบสามารถเรนเดอร์และเข้าใจ Layout ของหน้าเว็บได้เหมือนที่มนุษย์เห็น ในขณะเดียวกัน การแยก Sitemap สำหรับเนื้อหาสำคัญที่ต้องการให้ AI นำไปสรุปผล (High-value Content) จะช่วยให้การดึงข้อมูลมีประสิทธิภาพสูงขึ้น

ปรับรูปแบบ Content Layout ให้ AI สรุปข้อมูลได้แม่นยำ

โครงสร้าง HTML ที่สะอาดตาช่วยให้ AI แยกแยะใจความสำคัญได้ง่ายขึ้น การใช้ Tag H1-H3 ตามลำดับความสำคัญ และการจัดข้อมูลเปรียบเทียบให้อยู่ในรูปแบบ HTML Table แทนการใช้ไฟล์ภาพ จะช่วยให้ AI Overview สามารถดึงข้อมูลไปตอบคำถามประเภทเปรียบเทียบหรือสรุปจุดเด่นได้ทันที

| องค์ประกอบที่ AI ชอบ | ผลลัพธ์ที่ได้ |

| Bullet Points / Lists | ช่วยให้ AI สรุปขั้นตอนหรือคุณสมบัติได้ง่าย |

| HTML Tables | เพิ่มโอกาสการถูกดึงข้อมูลไปตอบคำถามเชิงเปรียบเทียบ |

| Clear Headers (H2, H3) | ช่วยให้ AI เข้าใจโครงสร้างและบริบทของเนื้อหา |

ประสบการณ์จากการปรับ Layout บทความรีวิวสินค้าพบว่า การเพิ่มส่วนKey Takeawaysไว้ที่ส่วนบนของหน้าเว็บโดยใช้ Bullet Points ช่วยเพิ่มโอกาสที่ AI จะดึงข้อความส่วนนั้นไปแสดงเป็น Featured Snippets ได้มากกว่าการเขียนบรรยายเป็นพาราโกรฟยาวๆ เพียงอย่างเดียว การเตรียมโครงสร้างเทคนิคอลให้พร้อมเช่นนี้เป็นรากฐานสำคัญที่จะนำไปสู่ความสำเร็จที่ยั่งยืนในยุค Generative Search

ความสำเร็จที่ยั่งยืนในยุค Generative Search

ความสำเร็จในยุค AI Search วัดจากการที่แบรนด์สามารถเปลี่ยนตัวเองจากเพียงผลการค้นหาให้กลายเป็นคำตอบที่น่าเชื่อถือที่สุดผ่านการสร้างโครงสร้างข้อมูลที่ AI เข้าใจง่ายและตรวจสอบความถูกต้องได้จริง

การสะสม Authority ที่ส่งผลต่อทราฟฟิกคุณภาพในระยะยาว

Authority ในยุค Generative Search เกิดจากการพิสูจน์ความเชี่ยวชาญในหัวข้อเฉพาะทาง (Topical Authority) อย่างต่อเนื่อง การสะสมความน่าเชื่อถือผ่านเนื้อหาที่มี Information Gain หรือการให้ข้อมูลใหม่ที่ไม่มีในแหล่งอื่น ช่วยให้ AI ระบุได้ว่าเว็บไซต์ของคุณคือแหล่งข้อมูลต้นน้ำที่ควรค่าแก่การส่งต่อทราฟฟิกคุณภาพให้

| องค์ประกอบ Authority | บทบาทในยุค AI Search |

| Information Gain | สร้างความแตกต่างจากข้อมูลทั่วไปที่ AI มักจะสรุปซ้ำๆ |

| Verified Expertise | การมีแหล่งอ้างอิงและข้อมูลเชิงประจักษ์ที่ AI สามารถตรวจสอบความถูกต้อง (Fact-check) ได้ |

บทเรียนจากการปรับปรุงโครงสร้างเนื้อหาในหลายโปรเจกต์พบว่า การเน้นตอบคำถามเชิงลึกที่ต้องใช้ประสบการณ์เฉพาะด้าน ไม่เพียงแค่ช่วยให้อันดับดีขึ้น แต่ยังทำให้ AI เลือกนำเนื้อหาไปสรุปในคำตอบ ซึ่งส่งผลให้ทราฟฟิกที่เข้ามามีความตั้งใจซื้อ (Intent) สูงกว่าปกติ

การเติบโตแบบทวีคูณเมื่อแบรนด์กลายเป็นแหล่งอ้างอิงหลักของ AI

เป้าหมายสูงสุดของการทำ SEO ยุคใหม่คือการทำให้ AI ระบุว่าแบรนด์ของคุณคือ Entity หรือตัวตนที่มีความเชี่ยวชาญสูงสุดในเรื่องนั้นๆ เมื่อระบบ Generative AI อย่าง ChatGPT หรือ Perplexity เริ่มอ้างอิงถึงแบรนด์ของคุณในฐานะแหล่งข้อมูลหลัก การเติบโตจะเกิดขึ้นแบบทวีคูณเพราะเป็นการสร้างความไว้วางใจในระดับที่ผู้ใช้งานไม่ต้องเสียเวลาเปรียบเทียบเอง

- Structure for Extr จัดรูปแบบเนื้อหาให้ AI ดึงข้อมูลไปใช้ได้ทันที เช่น การใช้ Bullet points สรุปประเด็นสำคัญไว้ที่ส่วนบนของหน้าเว็บ

- Entity Association: เชื่อมโยงแบรนด์กับคำสำคัญที่เป็นปัญหาของลูกค้าอย่างชัดเจน เพื่อให้ AI จดจำความสัมพันธ์นี้

- Originality: ผลิตงานวิจัย ข้อมูลสถิติ หรือ Case Study ที่เป็นของตัวเองเพื่อให้ AI จำเป็นต้องให้เครดิตแหล่งที่มา

จากการสังเกตพฤติกรรมการตอบกลับของ AI พบว่าหน้าเว็บที่สรุปใจความสำคัญแบบตรงไปตรงมาและมีโครงสร้างข้อมูลที่เป็นระเบียบ มักจะถูกเลือกไปเป็น Citation มากกว่าหน้าเว็บที่มีเนื้อหาเยิ่นเย้อ การปรับตัวสู่การเป็นแหล่งอ้างอิงจึงไม่ใช่เรื่องของการเพิ่มปริมาณเนื้อหา แต่คือการเพิ่มความคมชัดของข้อมูลที่ส่งมอบให้กับทั้งคนและ AI

การวางรากฐานด้าน Authority และการเป็นแหล่งอ้างอิงที่ทรงพลังจะกลายเป็นสินทรัพย์สำคัญที่ช่วยให้ธุรกิจอยู่รอดและเติบโตได้เหนือคู่แข่งในระยะยาว ซึ่งปัจจัยทั้งหมดนี้จะถูกรวบรวมเข้าด้วยกันเพื่อให้เห็นภาพรวมของการปรับตัวที่สมบูรณ์

การปรับแต่งเว็บไซต์สำหรับ AI (AIO) แตกต่างจากการทำ SEO แบบเดิมอย่างไร?

SEO แบบเดิมมุ่งเน้นไปที่การทำอันดับบนหน้าผลการค้นหาด้วย Keyword เป็นหลัก แต่การปรับแต่งสำหรับ AI หรือ AI Optimization (AIO) เน้นการสร้าง Semantic Connectivity เพื่อให้โมเดลภาษาอย่าง ChatGPT และ Gemini เข้าใจบริบทและความสัมพันธ์ของข้อมูล ทำให้เว็บไซต์ถูกเลือกไปเป็นแหล่งอ้างอิงในการตอบคำถามของผู้ใช้โดยตรง

ทำไมการใส่แค่ Keywords เพียงอย่างเดียวถึงเริ่มไม่ได้ผลในยุค Generative Search?

เนื่องจาก AI ในปัจจุบันไม่ได้ค้นหาข้อมูลจากคำที่ตรงกันเท่านั้น แต่ประมวลผลจากความเข้าใจเชิงลึก หากโครงสร้างข้อมูลซับซ้อนหรือไม่มีความเชื่อมโยงเชิงความหมาย AI จะไม่สามารถสรุปข้อมูลจากเว็บไปใช้งานได้ การเน้นแค่ Keyword โดยขาดโครงสร้างข้อมูลที่ชัดเจนจึงไม่เพียงพอต่อการถูกเลือกเป็นคำตอบแรก

Schema Markup มีความสำคัญอย่างไรต่อการทำงานของ AI Crawlers?

Schema Markup เปรียบเสมือนการติดป้ายระบุตัวตนให้ข้อมูลในเว็บไซต์ ช่วยให้ AI Crawlers เข้าใจได้ทันทีว่าเนื้อหานี้คืออะไร เป็นประเภทธุรกิจไหน หรือมีความสัมพันธ์กับหัวข้ออื่นอย่างไร การวาง Schema ขั้นสูงจึงเป็นกุญแจสำคัญที่ช่วยลดช่องว่างระหว่างภาษาคนกับภาษาที่โมเดล AI เข้าใจได้อย่างแม่นยำ